Дипфейки с каждым годом становятся более доступными и совершенными. Если к поддельным фото все уже давно привыкли, то вот голос, а тем более видео — все еще могут ввести в заблуждение. От нишевой технологии для энтузиастов в 2017 году, к нашему времени она разрослась до уровня инструмента, который может оказывать влияние на выборы. Как правило, предвыборные периоды становятся всплеском дипфейк роликов политического содержания, с каждым годом растет их качество и количество.

Согласно отчету AI Index Report 2024, число этических нарушений, связанных с ИИ, растет ежегодно. Доступ к технологии создания фальшивых видео и аудио (пусть и не самых качественных) есть уже буквально у каждого желающего с компьютером и доступом к интернету, а инструменты борьбы с ними отстают и крайне медленно внедряются на уровне крупных платформ по распространению контента.

Политические дипфейки совершенно точно уже оказывают влияние на выборы по всему миру, но пока идет дискуссия о том, насколько оно велико. Для дискредитации политических оппонентов беспринципные кандидаты, как правило в предвыборный период, распространяют фейковые заявления (видео или аудио), которые гарантировано вызовут негативную реакцию у избирателей.

Как, например, намеренье лидера идущей в парламент Словакии проевропейской партии "фальсифицировать голоса" и "удвоить цену на пиво". Или одобрение кандидатом в мэры Чикаго "полицейского насилия и превышения должностных полномочий". Неизвестно, оказали ли дипфейки решающее значение в их поражении на выборах, но определенно, они внесли вклад.

Как распознать дипфейк видео

Визуально. В основе дипфейк-алгоритмов лежит искусственный интеллект, который обучается на массивах данных. Нейросеть устанавливает с помощью доступных референсов, как выглядит человек, слоями конструирует его лицо, далее может синтезировать видео с аудио и липсинком (синхронизацией движения губ и звукового ряда).

На что стоит обратить внимание в подозрительных видео:

- Эффект "зловещей долины". Даже качественно сделанные дипфейки при просмотре вызывают чувство подозрения и беспокойства. В них всегда есть детали, которые выбиваются из "нормального". Если вы не можете объяснить, что конкретно не так с видео, но чувствуйте его нереальность, это признак дипфейка.

- Неестественное движение глаз и моргание. Раньше "дипфейк-персонажи" и вовсе могли не моргать, но сейчас эта проблема исправлена. Однако глаза все равно могут выглядеть подозрительно, и даже двигаясь оставаться "стеклянными" или "рыбьими", без глубины, как с картинки. Блики в них часто не соответствуют расположению источника освещения, меняется форма зрачков, движение может рассинхронизироваться. Если глаза — зеркало души, то определенно, у синтетических персонажей ее нет.

- Границы и переходы на акцентных частях лица (подбородок, брови, скулы, растительность на лице, веснушки, морщины, шрамы и родимые пятна). Они могут пропадать или исчезать, неестественно подергиваться, перемещаться при изменении ракурсов, смазываться в движении.

- Разница между лицом и остальным телом. Часто нарушены пропорции, различается качество "головы" и "остального тела". Есть разница и в тонах кожи, она неестественно отражает свет, выглядит нереалистично гладкой, глянцевой. Особенно заметно между разными кадрами и ракурсами.

- Плохая синхронизация речи и движения губ. Голос может не совпадать с движением рта, область губ смазывается. Зубы и язык зачастую неестественно яркие, может меняться их форма или они и вовсе пропадают, оставляя "черноту" во рту.

- Дыхание. Часто в дипфейках дыхание и речь не синхронизированы. Губы, гортань и грудь не двигаются в такт речи, так как эти элементы могут генерироваться отдельно.

- "Маскировка ошибок". Создатели дипфейк видео прекрасно осведомлены о слабых местах своих творений. Поэтому они стараются замаскировать их с помощью общего снижения качества видео, выбора освещения в сцене, используя частично прикрывающие лицо, голову или шею предметы одежды, очки, чтобы скрыть глаза.

Как работают deepfake технологии попытались объяснить устами сгенерированного Моргана Фримана. Голливудский актер известен большим количеством ролей, где объясняет персонажам различные детали и правила той или иной киновселенной.

Если мало опыта и визуально уверенности в том, что видео фейковое у вас нет, можно проверить косвенные признаки. Технологии быстро совершенствуются и через несколько лет отличить невооруженным глазом дипфейк от реального видео еще сложнее. В таком случае можно вспомнить про другой путь – анализ источника.

- Смотрите — кто автор или оригинальный источник. Как его можно верифицировать, насколько он заслуживает доверия. Если это заявление политика, опубликовано ли оно на официальной странице? Если вырезка из какой-либо передачи или выступления, указаны ли проверочные данные, к примеру название программы, телеканал, дата эфира? Можете ли вы найти оригинал выступления и самостоятельно проверить, что какое-либо сенсационное заявление, как минимум, не вырвано из контекста?

Желательно опираться на первоисточники, официальные источники или хотя бы на СМИ с хорошей репутацией.

- Проверяйте не только надежность источника, но и его подлинность. От имени реального ресурса могут распространять фейковые нарративы, пользуясь тем, что аудитория доверяет тому или иному СМИ. К примеру, мошенники не так давно использовали бренды TV8 и Newsmaker для кражи банковских данных.

- Важно вникать в суть видео. Подозрения может вызвать нелогичность действий, нехарактерное поведение, использование нетипичного языка и жестов. Человек надевающий на себя "чужую маску" не может скопировать все нюансы движений и поведения, это бросается в глаза.

- Продвижение ботами и "вирусные заголовки". Зачастую у фейковых видео крайне низкий уровень "прозрачности". Их распространяют боты, с провокационными описаниями, с "желтыми заголовками". С помощью ботов, реакций и комментариев создается "иллюзия большинства", человек видит, что "другие пользователи" не ставят под сомнение подлинность видео и опасается идти против мнения толпы. Отсутствие источника или сомнительный источник, накрутка реакций и однотипных комментариев от пустых профилей, могут стать поводом для подозрения, даже до начала просмотра.

- Проверяйте информацию в более чем двух источниках. Конечно, у обычного человека нет времени чтобы перепроверять каждую новость, но если речь идет о том, чем хочется поделиться, о каком-то важном заявлении, то его стоит перепроверить. Информация, как минимум, может быть вырвана из контекста, а худшем случае — оказаться абсолютной фальшивкой.

Как их создают?

Способы создания дипфейков с применением видео:

- Face swapping (замена лица) — подстановка в кадр лица другого человека. Встречаются более грубые варианты с наложение изображения поверх. Сложнее делать дипфейки, в которых используются технологии искусственного интеллекта для преобразования исходного лица.

- Face reenactment (реконструкция) — искусственное изменение выражения лица. В так называемых Lip-sync videos исходное лицо сохраняется, но голос, интонации и саму речь подделывают.

- Synthetic faces (синтез) — создание идентичностей, которых не существует в реальности. Неизвестный никому "новый человек" может рассказать, что стал жертвой каких-либо злоупотреблений, запускать ложные обвинения и дезинформацию, или хвалить мошеннические схемы получения им "легкого заработка".

Дипфейки в формате audio есть двух форматов: генерация искусственных аудиоданных с использованием технологии преобразования текста в речь (TTS) и изменение уже существующих аудиоданных.

В большинстве случаев используют комбинированные дипфейки с применением видео и аудио.

Где вы можете встретить дипфейки чаще всего?

Дипфейковые видео публикуются на разных платформах, но наибольшее распространение они получили в Facebook и WhatsApp. В Facebook их могут публиковать в комментариях фейковые аккаунты, а также продвигать с помощью различных групп. В WhatsApp сообщения пересылаются между чатами. Реже используется telegram, там, на отдельной территории "fake news" — все еще преобладает текстовый контент.

Соцсети и мессенджеры идеальная среда для распространения фейковых видео:

- Большая аудитория – существенная часть пользователей социальных сетей и мессенджеров слабо понимают как устроен интернет, распространение информации и не обладают критическим мышлением в этой сфере. Здесь же проявляется и "эффект согласия", когда фейковое видео сопровождает несколько десятков ботов, засыпающих его восхищенными комментариями и реакциями. Средний пользователь склонен перенять чужую точку зрения, вместо самостоятельного анализа.

- Изобилие информации – "бесконечная лента" в соцсетях, много читателей и реакций, но почти нет тех, кто может проверять достоверность той или иной публикации. А даже если кто-то разоблачает фейк, его голос тонет во множестве других комментариев. И на смену разоблаченному фейку, генерируется 10 новых.

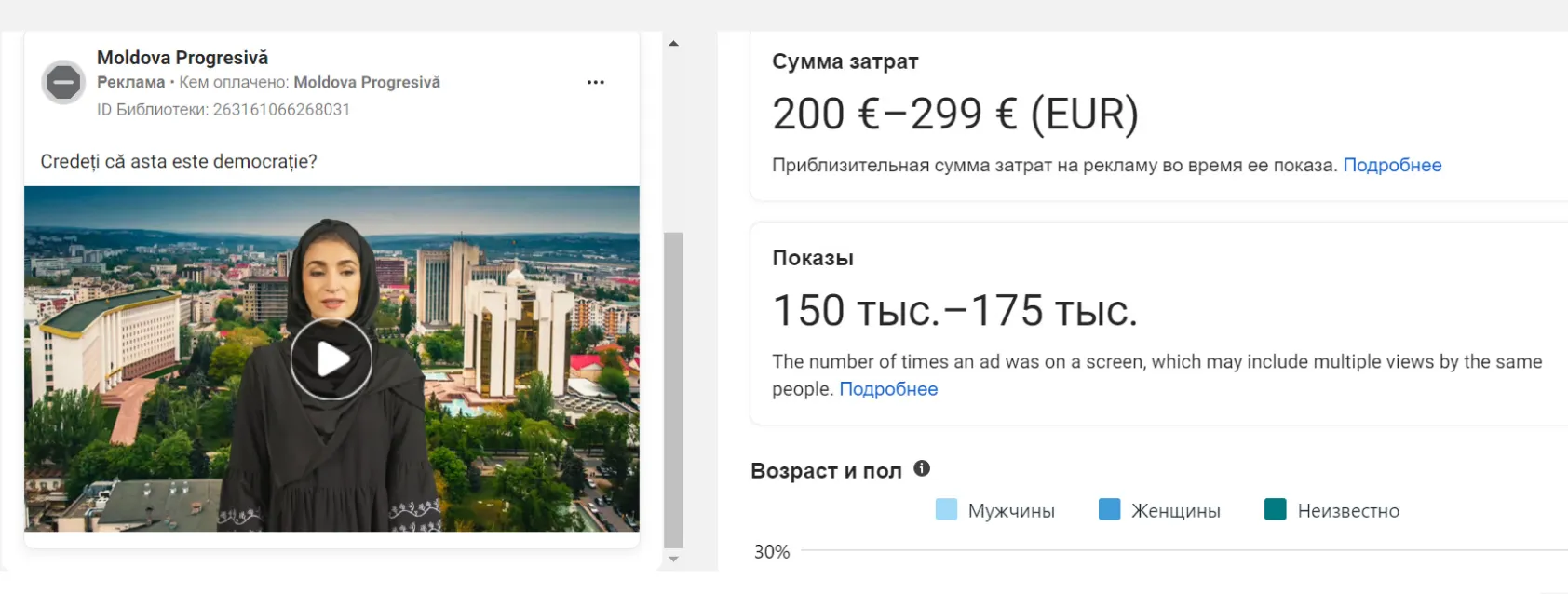

- Бесконтрольная реклама – facebook самая крупная социальная сеть планеты и ей остро не хватает модераторов контента и проверки рекламы. В последние годы регулярно рекламируются различные мошенники-брокеры, выгодные предложения покупок товаров или инвестиций, конечная цель которых – похищение ваших банковских данных мошенниками. В таких условиях и политические дипфейк видео тоже находят себе дорогу, продвигаясь за деньги. После жалоб от пользователей их блокируют, но как правило это занимает больше 2-3 суток и ролик уже успевает разойтись, найти своего зрителя.

- Алгоритмы сжимания видео – для экономии места и удобства пользователей социальные сети и мессенджеры снижают качество загружаемых видео. Люди привыкли смотреть контент на небольшом экране смартфона в условно "среднем" качестве, что помогает замаскировать технические огрехи дипфейков. Не считая того, что в большинстве фейковых видео специально меняют освещение и искусственно занижают качество картинки.

С момента создания этого видео об опасности технологии deepfake прошло уже 6 лет. Технологии значительно шагнули вперед, но идея о том, что кто-то может прикрываясь в прямом смысле слова "публичным лицом" вводить аудиторию в заблуждение становится еще более актуальная с каждым днем.

Что делать при столкновении с deepfake контентом?

Если вы подозреваете, что перед вами дипфейк видео, нужно сделать три вещи: просмотреть его, проверить источник и отправить жалобу.

- Пересмотрите видео внимательно, на большом экране и в наушниках. Останавливайте на фрагментах, которые кажутся подозрительными. Несмотря на рост качества фейковых видео, визуальные и аудио огрехи все еще заметны. Есть и технические инструменты, например сканер видео Deepware.

- Проверьте источник видео. Кто его распространяет, на что ссылается и где можно посмотреть первоисточник. Если это "секретный инсайд" у которого не найти концов, значит видео, вероятно, вброс.

- Сообщите о фальшивом видео отправкой жалобы через встроенную функцию в социальных сетях и мессенджерах. Пожаловаться также можно на источник фейка и ботов в комментариях.

Основные области применения дипфейков

Можно выделять три ключевых сферы применения дипфейков: развлечение, мошенничество и политика.

Подавляющее большинство дипфейков относится к порнографическому контенту. Другая существенная категория это различный развлекательный контент, к которому можно отнести различные замены лиц актеров в фильмах или роликах, пародии и мемы. В этой сфере применение дипфейков не скрывается, а открыто используется для создания развлекательного контента. Особенно популярны ролики на тему, "А что если?", к примеру, роль в культовом фильме сыграл бы другой актер?

Мошенничество – попытка выдать себя за другого человека с помощью дипфейк технологий со злым умыслом, как правило, для получения доступа к чужим деньгам или к компромату. Чаще используется подделка голоса, например, чтобы обмануть знакомого или родственника жертвы, сотрудника банка. Реже для провокаций и получения компроментирующих заявлений, как например делают приближенные к российским спецслужбам пранкеры "Вован и Лексус".

Под прицелом – публичные люди и политики

Третий пункт - политика. Пока не такой значительный по объему, но вызывающий беспокойство высоким фактором риска.

Обычные люди, когда решают прикоснуться к дипфейк-технологиям, в первую очередь пробуют эксперименты с собственным изображением. Заменой своего лица или лица знакомого на актера популярного фильма или другой известной личности, получается хоть и кривовато, но вполне забавно. Если же пробовать сделать качественный дипфейк, происходит неизбежная нехватка референсов. Нейросети просто не из чего "лепить" образ, нескольких фото или видео бывает недостаточно.

С публичными людьми злоумышленникам гораздо легче. Есть десятки часов видео в высоком разрешении, образцы голоса, фотографии с разных ракурсов. Это все "пластилин" в руках нейросети. На основании качественных и объемных по содержанию референсов, а также с учетом обрабатывающих мощностей и затраченного времени, могут получать дипфейки, которые очень тяжело отличить от реального видео.

Но пока упор делается на количество, а не качество. Большинство дипфейк видео создают впопыхах, на основании одного референса, с процедурной анимацией губ и движения головы. Мошенники используют образы публичных людей для рекламы своих скам-проектов. В политические дипфейки вкладывают больше и стараются их использовать точечно, в моменты избирательных компаний. Да, такие и видео разоблачают, но они успевают нанести свой урон.

Молдове есть чего опасаться?

Пока трудно предсказать, будут ли активно использоваться дипфейк технологии в грядущей избирательной кампании на президентских выборах и референдуме в Молдове. Можно сделать прогноз, что такие ролики появятся, но на них явно не делается основная ставка.

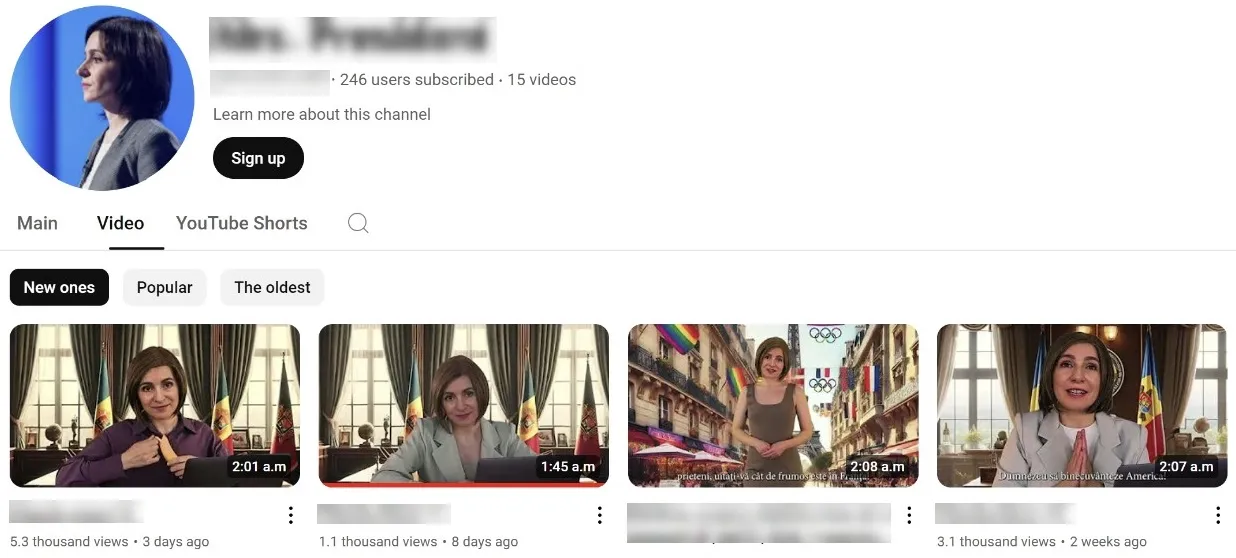

В Молдове безусловным лидером по количеству попадания в дипфейк видео стала президент Майя Санду, которая баллотируется этой осенью на второй срок. Создатели не смогли добиться должного уровня сходства и решили делать "юмористический контент", якобы от лица главы государства озвучивая различные штампы российской пропаганды в отношении властей в Кишиневе и ЕС.

Ролики активно распространяли в социальных сетях боты, оставляя ссылки под комментариями в группах молдавских СМИ. Публиковали их и в телеграмм-каналах лояльных РФ молдавских деятелей.

После публикации одного из первых фейковых видео, еще в конце прошлого года в администрации президента обратили внимание на эти атаки на образ главы государства и призвали граждан быть осторожными при столкновении с подобных контентом.

"В условиях гибридной войны против Молдовы и демократического руководства, имидж главы государства используют через фальсификации изображения и голоса. Фейковые кадры используют с целью провоцирования недоверия и раскола в обществе и, как следствие, ослабление демократических институтов Молдовы", - отмечали в АП.

Авторы не смогли найти женщину с похожей комплекцией и ровно обрезать края лица. Решили "замаскировать" огрехи закрытым платьем. После жалоб пользователей и обращения от администрации президента ролик удалили, а группу заблокировали.

Большая часть дипфейков, которые курсируют в информационном пространстве Молдовы, касаются мошеннических схем и не имеют отношения к политике. Но ситуация может усугубиться в будущем.

После появления нескольких политических дипфейк роликов, осенью прошлого года власти Молдовы, совместно с руководством других европейских государств, обратились к крупным компаниям в сфере IT, в том числе к Meta, владеющей соцсетями Facebook и Instagram, с призывом принять меры против дезинформации и манипуляций в социальных сетях, которые "подрывают мир и стабильность во всей Европе". Уже сейчас во многих странах осознают, как опасна может быть данная технология и насколько обычные люди не готовы критически воспринимать подобные манипуляции. Особенный риск — электоральный период, когда общество политизировано, расколото, накалено.

Очередная победа машины над человеком?

Экспериментальный проект CounterCloud продемонстрировал, насколько легко искусственный интеллект может создавать и распространять фейковый контент.

Исследователи построили автоматизированную модель, которая ежедневно создавала 20 фейковых новостей и 50 твитов с ложной информацией. Два месяца содержания такого "ИИ-дезинформатора" обошлось всего в $800. Успех превзошел самые смелые ожидания — более 90% читателей поверили в сообщения, а социальные сети ничего не смогли на автоматизированном уровне противопоставить фейкам.

В результате эксперимента пришли к неутешительному выводу — уже сегодня существуют доступные технологии, которые позволяют дешево генерировать фейковую информацию и использовать ее как оружие в больших масштабах. При затратах всего в $4000 долларов можно генерировать по 200 статей в день (объем 40 полноценных новостных агентств), без какого-либо участия человека. Учитывая большие объемы информации, подобные вбросы в предвыборные периоды могут добиваться своих целей, так как на коротком отрезке появляется "цунами" фейков, от текстов и аудио, до видео и даже имитации прямых эфиров с "кандидатом".

Подробнее об эксперименте (en).

Исследователи предложили 5 шагов по сдерживанию угрозы фейковой информации:

1. Внедрение расширений по обнаружению созданного с применением ИИ контента в браузеры.

2. Требование к платформам в обязательном порядке помечать контент, созданный с помощью ИИ.

3. Обязать поставщиков обнаруживать вредоносный контент с помощью ИИ (использовать один искусственный интеллект для противостояния другому).

4. Регулировать использования высокопроизводительного ИИ, на базовом уровне снизить его возможности для создания высококачественных дипфейк видео.

5. Просвещение граждан о дезинформации, созданной с помощью ИИ, методах обнаружения и борьбы с ней.

Самый мощный и самый сложный из них — просвещение общества по данной теме. Поскольку большинство людей находятся в "информационном пузыре", запертые в своих мнениях и убеждениях, своей информационной зоне комфорта, не обращая внимание на информацию, которая противоречит сформированным представлениям о мире.

Помните, что фейки изначально создаются как вирусный контент. Не спешите распространять сенсационные новости, пока не нашли им подтверждения.